生成式人工智能(GenAI)的出现使人们对GPU和其他形式的加速计算的需求大大增加。为了帮助公司以可预测的方式扩大其加速计算投资,GPU巨头英伟达(Nvidia)和几个服务器合作伙伴借鉴了高性能计算(HPC)领域的经验,推出了企业参考架构(ERA)。

大型语言模型(LLM)和其他基础模型引发了GPU的淘金热,Nvidia可以说是最大的受益者。2023年,该公司出货了376万台数据中心GPU,比2022年多出100多万台。2024年,这一增长并没有放缓,因为公司继续争夺GPU来为GenAI提供动力,这促使Nvidia成为世界上最有价值的公司,市值为3.75万亿美元。

Nvidia近期推出了ERA计划,在此背景下,公司疯狂地扩大计算规模,以构建和服务GenAI应用程序。该公司与ERA的目标是提供一个蓝图,帮助客户以可预测和可重复的方式扩展其HPC计算基础设施,从而最大限度地降低风险并最大限度地提高结果。

英伟达表示,ERA计划将加快服务器制造商的上市时间,同时提高性能、可扩展性和可管理性。Nvidia表示,这种方法还增强了安全性,同时降低了复杂性。到目前为止,英伟达已经与戴尔科技、惠普企业、联想和Supermicro签订了ERA协议,预计将有更多的服务器制造商加入该计划。

该公司在一份关于ERA的白皮书中表示:“通过从超级计算世界引入相同的技术组件,并将其与基于数十年经验的设计建议打包在一起,英伟达的目标是通过灵活且经济高效的配置简化方法,消除从头开始构建这些系统的负担,消除部署中的猜测和风险。”

ERA方法利用了经认证的GPU、CPU和网络接口卡(NIC)服务器配置,Nvidia称这些配置“经过测试和验证,可提供大规模性能”。这包括英伟达Spectrum-X AI以太网平台、Nvidia BlueField-3 DPU等。

根据Nvidia的白皮书,ERA针对4到128个节点的大规模部署量身定制,包含32到1024个GPU。这是该公司看到将其数据中心转变为“人工智能工厂”的最佳地点。它也比该公司现有的NCP参考架构小一点,该架构专为大规模基础模型训练而设计,从至少128个节点开始,扩展到100000个GPU。

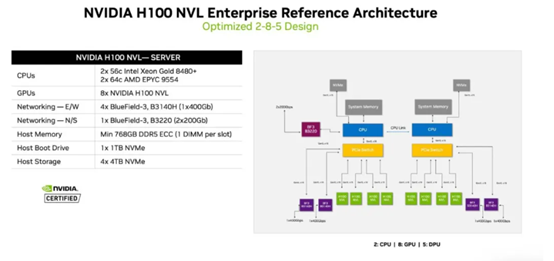

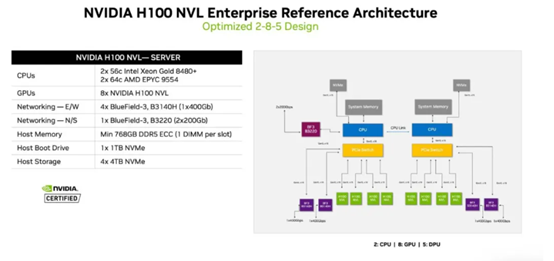

英伟达ERA参考配置(来源:英伟达ERA概览白皮书)

ERA需要几种不同的设计模式,具体取决于集群的大小。例如,Nvidia的“2-4-3”方法包括一个2U计算节点,该节点最多包含两个CPU、四个GPU和三个NIC。Nvidia表示,这可以在8到96个节点的集群上工作。或者,有2-8-5设计模式,它要求4U节点配备多达8个GPU、5个NIC和2个CPU。Nvidia表示,这种模式在集群中从4个节点扩展到64个节点。

英伟达ERA参考配置(来源:英伟达ERA概览白皮书)

英伟达ERA参考配置(来源:英伟达ERA概览白皮书)

Nvidia表示,与服务器制造商在经过验证的加速计算架构上合作,有助于推动客户以快速安全的方式建立人工智能工厂。该公司在其白皮书中表示:“传统数据中心向人工智能工厂的转型正在通过整合先进的计算和网络技术来满足人工智能应用程序的大量计算需求,从而彻底改变企业处理和分析数据的方式。”